В конце прошлого года мне нужно было выкачать несколько сайтов, потому что в ручную сохранять текстовую информацию дело очень кропотливое и долгое. Начал искать соответствующие приложения. Но, как оказалось, этих приложений единицы, к тому же стоят они не мало.

Mac OS UNIX-подобная операционная система, следовательно, можно попробовать выкачать с помощью wget. Но не тут-то было, wget отсутствует в Mac OS. Пошел на поиски wget для Mac OS и вскоре нашел нужный пакет. Ну а дальше установка и работа в консоли.

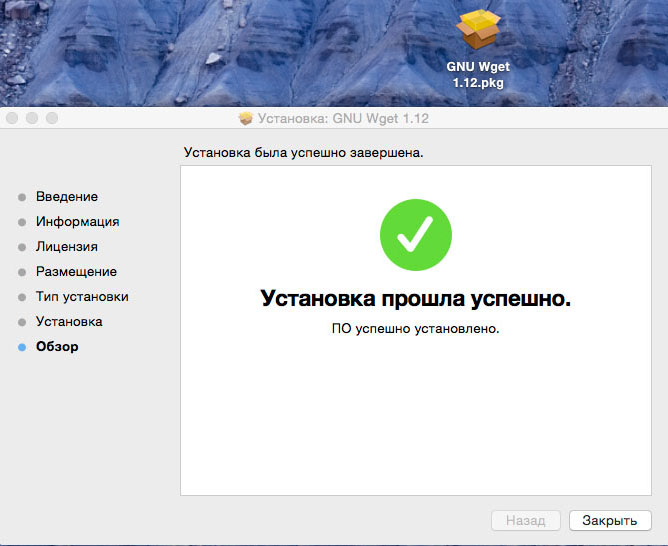

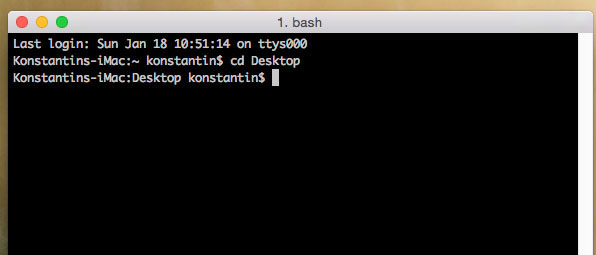

Устанавливаем wget.

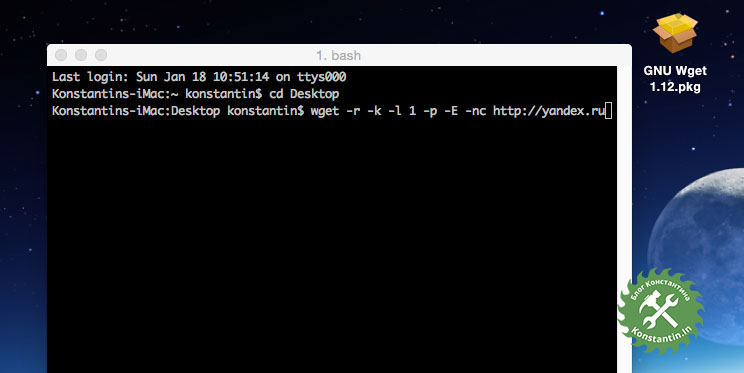

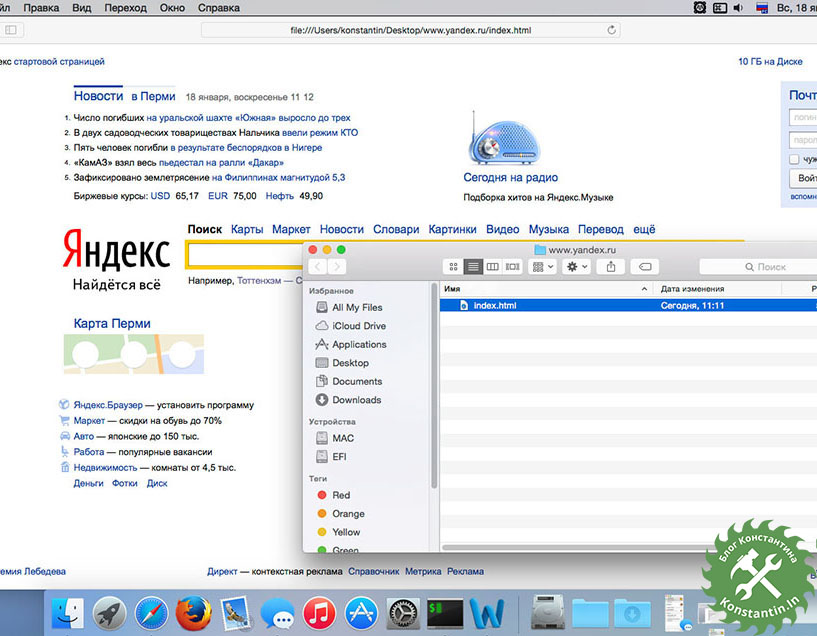

wget -r -k -l 1 -p -E -nc http://yandex.ru

-r – данный параметр указывает на то, что нужно рекурсивно переходить по ссылкам на скачиваемом сайте.

-k – данный параметр используется для того, чтобы wget преобразовал все ссылки в загруженных файлах для последующего просмотра в автономном режиме.

-l – данный параметр задает максимальную глубину вложенности страниц, которые wget должен скачать. В своем примере я указал 1 (единица), в результате загрузилась только главная страница. Рекомендуется устанавливать данный параметр на значении 5-8. Если установить большее значение, то wget может “зарыться” так глубоко, что скачивание будет идти бесконечно.

-p – данный параметр нужен для того, чтобы загрузить все файлы, которые нужны для корректного отображения страниц (изображения, css, java и т.д.).

-E – данный параметр добавляет к загруженным файлам (страничкам) расширение .html.

-nc – данный параметр исключает перезапись существующих файлов. Это может быть полезно, если сайт не загрузился за раз, либо загрузка была прервана по каким-либо причинам.

Как видите, все очень просто!

Комментариев: 26 RSS

1 Игорь 05-05-2015 13:55

Большое спасибо! Благодаря Вам, смог сохранить необходимый сайт, не понял как все произошло, но задача выполнена, следовал вашим понятным подробным инструкциям. Еще раз Большое Спасибо!

2 Konstantin 05-05-2015 16:36

Игорь, пожалуйста! Действительно, все просто и не надо устанавливать дорогие приложения.

3 Дмитрий 22-06-2015 13:37

просто супер! спасибо хотя я чайник в этом деле просто внимательно прочитал и все сделал как написано скачал сайт который мне нужен! Автор спасибо!

4 Konstantin 22-06-2015 18:00

Дмитрий, пожалуйста!

5 Anton 18-08-2015 15:55

Подскажите пожалуйста, а что делать, если все страницы на сайте прописаны через http:// ? тогда скачивается только index.html, какую глубину бы не устанавливал. и следовательно все данные кроме главной грузятся с сайте донора. Заранее благодарю за ответ.

6 Konstantin 18-08-2015 17:30

Anton, странно, я уже скачал много сайтов, все страницы начинаются с http. Проблем не возникало. Может не правильно понял ваш вопрос...

7 Anton 10-10-2015 12:12

-e robots=off заставит wget игнорировать robots.txt

8 Артур 26-10-2015 20:38

Добрый день! Хочу загрузить большой сайт со всей базой товаров. Около 2 миллионов. На сайте работает поиск по сайту. Будет ли он работать на моем компьютере по завершению загрузки? Сайт весит 2 ТБ.

9 Konstantin 05-11-2015 05:07

Здравствуйте, Артур! Сомневаюсь, что такой большой сайт можно будет скачать и ссылки потом будут работать правильно. Но попробовать можно.

10 тоже Артур) 11-12-2015 01:58

Спасибо! Все круто!

11 Konstantin 11-12-2015 11:02

Артур, пожалуйста!

12 Андрей 02-02-2016 13:13

Спасибо большое! Автор ты просто спаситель! Все работает, оперативку не жрет, не глючит, А про скорость я вообще молчу! ЭТО ГЕНИАЛЬНО

13 Konstantin 02-02-2016 13:59

Андрей, пожалуйста!

14 Мария 16-02-2016 15:18

Спасибо, дорогой друг!!!

15 Konstantin 16-02-2016 21:04

Мария, пожалуйста!

16 Александр 07-03-2016 19:12

Привет, не скажите возможно ли (и как) при этом скачивать сайт требующий авторизации?

17 Konstantin 20-03-2016 22:44

Привет, Александр. Не скажу, не пробовал...

18 Vadim 10-02-2017 21:33

Скажите, а есть ли возможность поставить на паузу закачку? Или просто отключиться от сети и когда она появится скачивание продолжится автоматически?

19 Konstantin 12-02-2017 00:25

Vadim, считаю, такой возможности нет.

20 SergeyK 29-06-2017 18:32

Добрый день! Раньше скачивал сайты, адрес которых прописан на латинице, без проблем. Сегодня попробовал скачать сайт на кириллице, не получилось. Может быть вы сталкивались с данным вопросом? Как его решить?

21 Петр 11-06-2018 15:19

Добрый день. А что значит use `--no-check-certificate'? Где включить эту настройку? Спасибо

22 Konstantin 18-06-2018 21:49

Петр, --no-check-certificate нужно выполнить в консоли вместе с другими параметрами.

23 Ян 14-02-2019 23:53

Сайты с протоколом https тоже можно скачать? Потому что у меня ошибки 403, 404 появляются

24 Konstantin 27-02-2019 21:12

Ян, не пробовал, не скажу. Возможно статья устарела.

25 Alexander_Ford 19-10-2020 20:39

Автор, спасибо за такую полезную статейку. Сохраню твою инструкцию в закладки. Ты выручил!

26 Konstantin 20-10-2020 13:16

Пожалуйста!

Только наверное wget поновее скачать...